Travaux Phares

Publications et ressources essentielles.

Tendances & Statistiques IA

Chiffres sélectionnés montrant la croissance de l'intelligence artificielle.

Puissance de calcul

La puissance de calcul d'entraînement des modèles IA de pointe a augmenté de 5x par an depuis 2020.

ⓘIntervalle de confiance à 90% : 4x à 6x.

Performance de calcul

La performance de calcul des GPUs pour FP32 a augmenté de 1.35x par an depuis 2012.

ⓘIntervalle de confiance à 90% : 1.2x à 1.5x.

Coût d'entraînement

Le coût d'entraînement des modèles IA de pointe a augmenté de 3.5x par an en USD depuis 2016.

ⓘIntervalle de confiance à 90% : 2.5x à 4.5x.

Données sur l'IA

Aperçus sélectionnés de nos bases de données.

La puissance de calcul des puces NVIDIA double tous les 10 mois

La puissance de calcul totale disponible des puces NVIDIA a augmenté d'environ 2,3x par an depuis 2019, permettant l'entraînement de modèles toujours plus grands. La génération Hopper de puces IA NVIDIA représente actuellement 77% de la puissance de calcul totale de tous leurs matériels IA. À ce rythme de croissance, les générations plus anciennes tendent à contribuer moins de la moitié du calcul cumulé environ 4 ans après leur introduction.

Notez que cette analyse n'inclut pas les TPU ou autres accélérateurs IA spécialisés, pour lesquels moins de données sont disponibles. Les TPU peuvent fournir une puissance de calcul totale comparable aux puces NVIDIA.

Puissance de calcul totale installée (FLOP/s)

Plus de 30 modèles d'IA ont été entraînés à l'échelle de GPT-4

Les plus grands modèles d'IA actuels sont entraînés avec plus de 10²⁵ opérations en virgule flottante (FLOP) de calcul. Le premier modèle entraîné à cette échelle était GPT-4, lancé en mars 2023. En juin 2025, nous avons identifié plus de 30 modèles d'IA annoncés publiquement par différents développeurs d'IA qui dépassent selon nous le seuil de 10²⁵ FLOP de calcul d'entraînement.

L'entraînement d'un modèle de cette échelle coûte des dizaines de millions de dollars avec le matériel actuel. Malgré le coût élevé, nous nous attendons à une prolifération de tels modèles — nous avons observé en moyenne environ deux modèles dépassant ce seuil annoncés chaque mois au cours de 2024. Les modèles entraînés à cette échelle seront soumis à des exigences supplémentaires en vertu de la loi européenne sur l'IA, qui entrera en vigueur en août 2025.

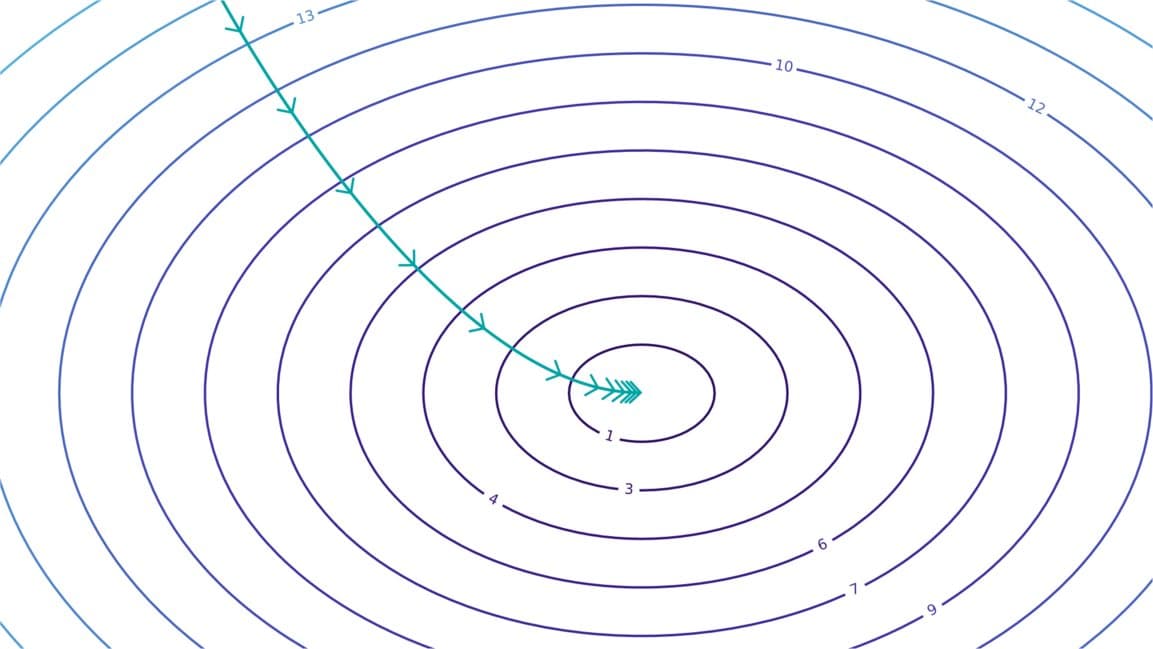

La puissance de calcul d'entraînement des modèles d'IA notables double environ tous les six mois

Depuis 2010, la puissance de calcul d'entraînement utilisée pour créer les modèles d'IA croît à un rythme de 4,4× par an. La majeure partie de cette croissance provient de l'augmentation des dépenses, bien que les améliorations matérielles aient également joué un rôle.

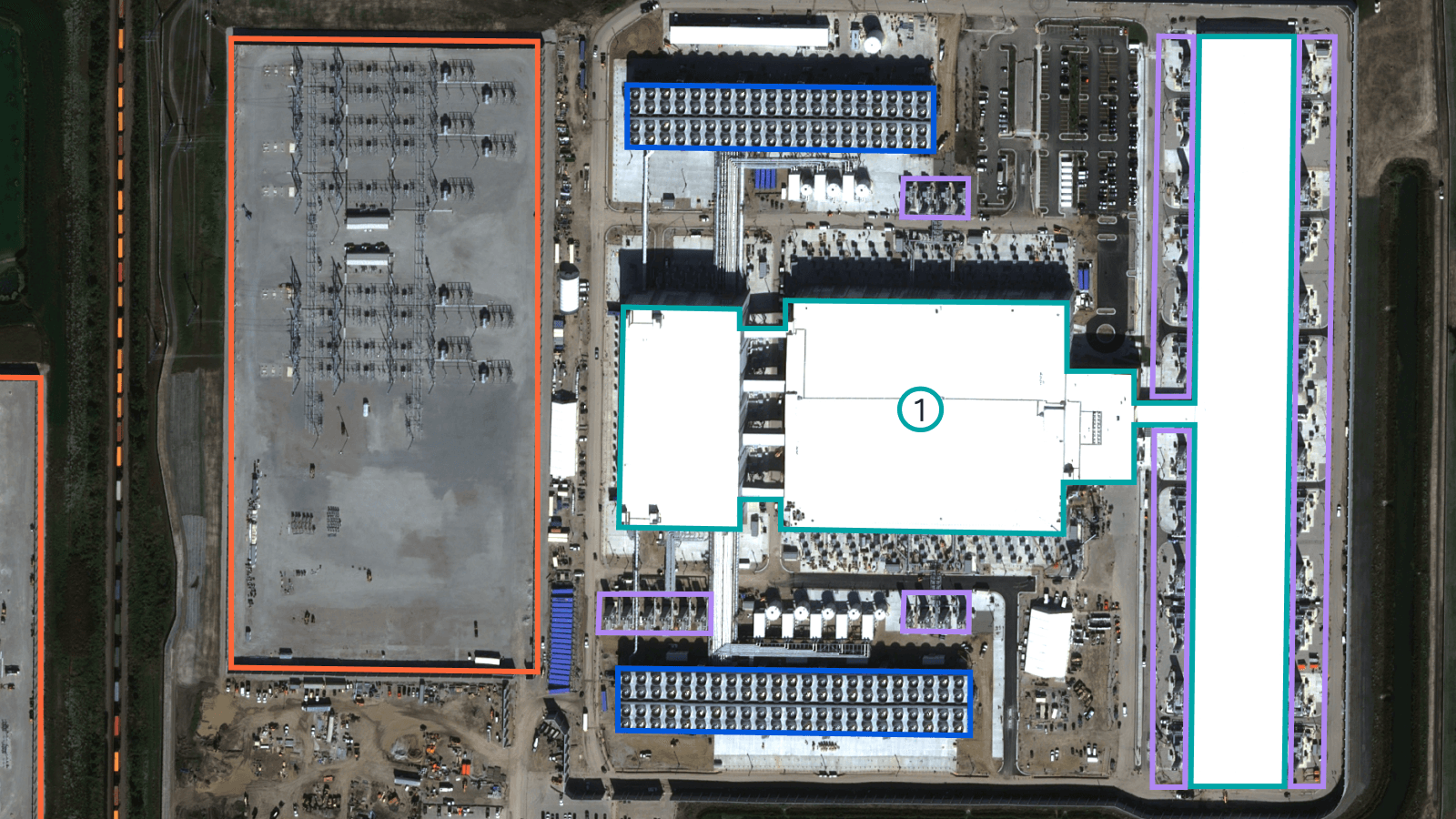

Les grandes entreprises d'IA possèdent des centaines de milliers de puces IA de pointe

Les principales entreprises technologiques mondiales — Google, Microsoft, Meta et Amazon — possèdent une puissance de calcul IA équivalente à des centaines de milliers de NVIDIA H100. Ce calcul est utilisé à la fois pour leur développement d'IA interne et pour les clients cloud, y compris de nombreux laboratoires d'IA de premier plan tels qu'OpenAI et Anthropic. Google pourrait avoir accès à l'équivalent de plus d'un million de H100, principalement grâce à leurs TPU. Microsoft possède probablement le plus grand stock d'accélérateurs NVIDIA, avec environ 500 000 équivalents H100.

Une part importante de la puissance de calcul IA est détenue collectivement par des groupes autres que ces quatre, notamment d'autres sociétés cloud comme Oracle et CoreWeave, des utilisateurs de calcul comme Tesla et xAI, et des gouvernements nationaux. Nous mettons en évidence Google, Microsoft, Meta et Amazon car ils disposent probablement du plus de calcul, et il y a peu de données publiques pour les autres.

La puissance requise pour entraîner les modèles d'IA de pointe double chaque année

L'entraînement de modèles de pointe nécessite une quantité d'énergie importante et croissante pour les GPU, les serveurs, le refroidissement et autres équipements. Cela est motivé par une augmentation du nombre de GPU ; la consommation d'énergie par GPU augmente également, mais seulement de quelques pour cent par an.

Le calcul d'entraînement a augmenté encore plus rapidement — environ 4× par an. Cependant, l'efficacité matérielle (une amélioration de 12× au cours des dix dernières années), l'adoption de formats de précision inférieure (une amélioration de 8×) et des exécutions d'entraînement plus longues (une augmentation de 4×) représentent une diminution d'environ 2× par an des besoins en énergie par rapport au calcul d'entraînement.

Articles & Rapports

Nos dernières analyses et recherches sur l'intelligence artificielle

Données & Ressources

Collaborer avec OkurAI

Nous sommes fiers de travailler avec des entreprises visionnaires qui comprennent l'importance de la visibilité dans les moteurs d'IA. Vous envisagez de booster votre présence en ligne avec le GEO ? Contactez Tanse

Nos clients nous font confiance

Rejoignez la liste d'attente du Pass IA

Soyez les premiers à tester le Pass IA : un abonnement unique pour accéder à toutes les nouvelles intelligences artificielles. Inscrivez-vous à notre whitelist et découvrez l'avenir de l'IA en avant-première.